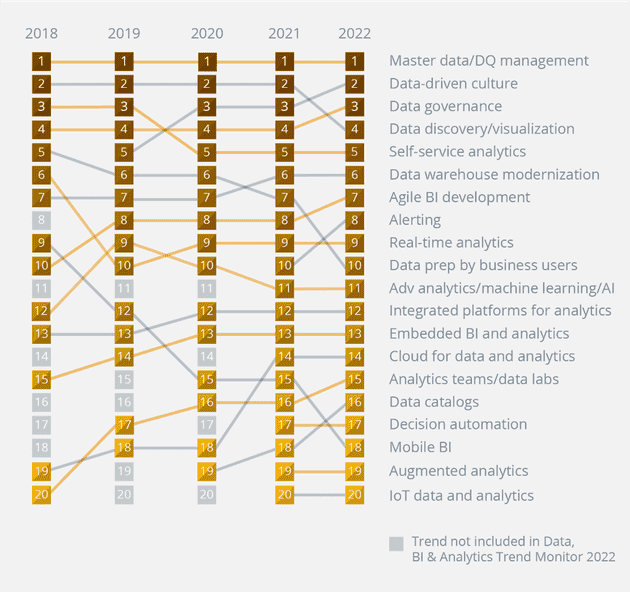

Die Data, BI & Analytics Trends 2022 im Überblick

Der BARC Data, BI & Analytics Trend Monitor 2022 ist die größte weltweite Trendbefragung zu Business Intelligence und Data Analytics. Das sagen 2.396 BI-Anwender:innen, Anbieter und Berater:innen über ihre Top Trends. Zur dazugehörigen Infografik geht es hier.

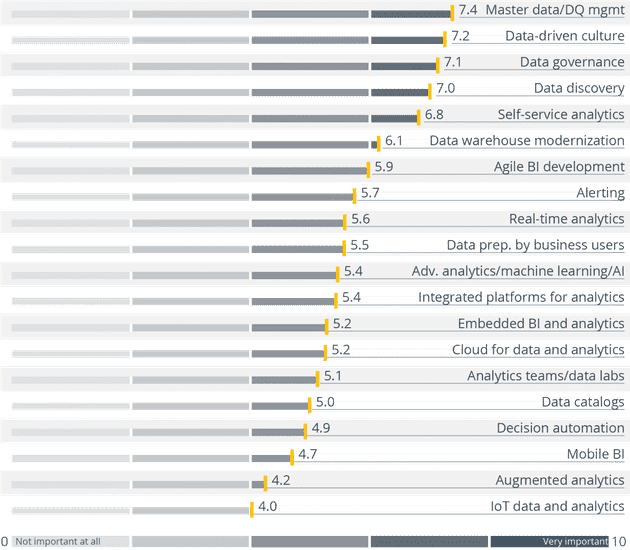

Platz 1: Stammdaten- und Datenqualitätsmanagement

Auch 2022 bleiben die beiden Trends Stammdaten- und Datenqualitätsmanagement an erster Stelle. Die Bedeutung dieser Themen lässt sich ganz einfach erklären: Nur auf der Grundlage korrekter Daten können Menschen die richtigen Entscheidungen treffen.

Entscheidungsprozesse und operative Maßnahmen sind auf zuverlässige Daten angewiesen. Mit Big Data stehen Unternehmen vor der Herausforderung, große und vor allem heterogene Datenmengen zu speichern und zu verwalten.

Platz 2: Data-driven culture

Die Etablierung einer datengetriebenen Unternehmenskultur hat weiter an Bedeutung gewonnen. Somit landet data-driven culture auf Platz zwei.

Platz 3: Data Governance

Data Governance schafft es im BARC Data, BI & Analytics Trend Monitor 2022 auf das Treppchen. Es ist als Steuerungsmechanismus für die Datenstrategie erforderlich. Eine Governance enthält Richtlinien und Rahmenbedingungen, mit denen Daten, Aufgaben und Geschäftsprozesse verwaltet und überwacht werden.

Platz 4: Data Discovery

Der Trend Data Discovery hat zwei Plätze eingebüßt. Data Discovery ist ein Prozess, bei dem Fachanwender:innen selbst Muster und Ausreißer in Daten entdecken. Benutzerführung und Automatisierung dieser Werkzeuge stehen für die meisten Anbieter ganz oben auf der Agenda.

Platz 5: Self-Service Analytics

Seit zehn Jahren sind Self-Service Analytics oder Self-Service-BI ein Hypethema. Es steht es weiterhin auf der Agenda vieler Unternehmen und hat nach unseren Umfrageergebnissen nach wie vor eine hohe Priorität und Nachfrage.

Unternehmen konzentrieren sich heute nicht mehr nur darauf, ihre Mitarbeiter:innen mit entsprechenden Funktionen auszurüsten. Sie müssen die Balance halten, Daten und ihren Zugriff zum einen zu demokratisieren und zeitgleich eine qualitativ hochwertige Datenbasis sicherzustellen.

Die fünf wichtigsten Trends bilden die Grundlage für Unternehmen, ihre eigenen Daten nutzen zu können

Viele Unternehmen sind noch dabei, sich auf die veränderten Anforderungen infolge der Covid-19-Pandemie anzupassen. Auch wenn sich längerfristige Veränderungen hin zu einer neuen Normalität abzeichnen, hat sich das Tagesgeschäft noch lange nicht eingependelt.

Ein Blick auf die diesjährigen Data, Business Intelligence & Analytics Trends zeigt, dass Unternehmen nach wie vor daran arbeiten, sich langfristig optimal zu positionieren und an den grundlegenden Voraussetzungen für ihre Datennutzung arbeiten.

“Das Gesamtbild zeigt, dass sich Unternehmen auf die grundlegenden Aspekte der Nutzung und des Managements ihrer Daten konzentrieren, bevor sie ihre Prioritäten auf fortschrittlichere Methoden verlagern“

“Das Gesamtbild zeigt, dass sich Unternehmen auf die grundlegenden Aspekte der Nutzung und des Managements ihrer Daten konzentrieren, bevor sie ihre Prioritäten auf fortschrittlichere Methoden verlagern“, sagt Dr. Carsten Bange, CEO und Gründer von BARC zu den Ergebnissen.

„Wir erleben ein weiteres Jahr ohne Hype-Trends. Stattdessen gehen Unternehmen den Ursachen ihrer Herausforderungen auf den Grund, wie beispielsweise der Datenqualität, und arbeiten am Aufbau einer ganzheitlichen datengetriebenen Unternehmenskultur.“

Bereit für eine datengetriebene Unternehmenskultur

Seit der Aufnahme in den Trend Monitor im Jahr 2019 zählt die datengetriebene Unternehmenskultur stets zu den fünf wichtigsten Trends und gewinnt immer mehr an Bedeutung. „Dies lässt sich durch das wachsende Bewusstsein erklären, dass es unerlässlich ist, eine datengetriebenen Unternehmenskultur zu fördern, wenn Unternehmen ihr Datenpotenzial voll ausschöpfen möchten“, erklärt Bange.

Eine datengetriebene Unternehmenskultur wird in allen Branchen und allen geografischen Regionen als wichtig erachtet. Best-in-Class-Unternehmen haben dieses Thema schon seit einiger Zeit auf ihrer Agenda und stellen vermutlich auch die notwendigen Ressourcen für die Umsetzung bereit.

Es gibt aber auch ermutigende Anzeichen dafür, dass sogenannte „Laggards“ (dt. Nachzügler-Unternehmen) heute mehr Interesse an der Etablierung einer datengetriebenen Unternehmenskultur haben als früher.

„Die Schaffung einer datengetriebenen Unternehmenskultur erfordert Mut, kritisch zu denken und die Bereitschaft, Verantwortung für Daten an Business User zu übertragen. Unternehmen müssen sich darüber im Klaren sein, dass ein tiefgreifender kultureller Wandel zeitaufwändig ist und wahrscheinlich auf Widerstand stoßen wird“, sagt Bange.

Welche weiteren Ergebnisse zeigt der Data, BI & Analytics Trend Monitor 2022? Er bietet eine detaillierte Auswertung und Gewichtung der einzelnen Analytics Trends nach Region und Branche. Schauen Sie rein!

In diesen 5 Handlungsfeldern wirken die Data, BI & Analytics Trends

Wir blicken weit in die Zukunft: Bei BARC beobachten unsere Analyst:innen derzeit mehr als 50 IT-Trends, die die Zukunft von Data & Analytics beeinflussen. Wir zeigen auf, welche Buzzwords auf Ihrer Agenda stehen sollten. Dabei haben wir fünf Trendbewegungen für die kommenden Jahre identifiziert.

1. Nutzer:innen befähigen

Wir sehen, dass in der Zukunft von BI (Business Intelligence) die Nutzer:innen weiter in den Mittelpunkt rücken. Unternehmen müssen heute flexibler und schneller auf Veränderungen reagieren. Deshalb werden BI-Nutzer:innen mehr Möglichkeiten sowie Verantwortung übertragen.

Self-Service BI / Self-Service Analytics ist inzwischen in vielen Unternehmen angekommen. Die Herausforderung in den nächsten Jahren wird sein, die gewachsene Software-Landschaft zu ordnen. Power Usern und BI-Anwender:innen sollten Richtlinien im Zuge einer Data Governance an die Hand gegeben werden.

2. Data Management & Analytics erweitern

Aufgrund der steigenden Datenvolumina und neuen Anforderungen in Unternehmen bleibt die Erweiterung von Datenmanagement und Analytics auch künftig relevant. Wir sehen, dass Unternehmen vielfältiger mit Daten arbeiten werden. Sie beziehen beispielsweise neue Quellen und Arten von Daten in ihre Arbeit ein. Neue Technologie und Speicher-Konzepte wie beispielsweise im Rahmen des Big Data Management geben dabei Hilfestellung.

Außerdem sehen wir einen steigenden Bedarf nach Advanced Analytics, AI und Deep Learning, da klassische Berichte und Analysen die Anforderungen von Unternehmen nicht mehr vollends erfüllen. Explorative BI und Data Discovery eröffnen Fachanwender:innen die Möglichkeiten, Muster und Zusammenhänge in Daten zu entdecken.

3. Datenarchitektur modernisieren

Die Heterogenität von Daten, Systemen und Anwendungen steigt. Das hat zur Folge, dass bestehende Architekturen erweitert und modernisiert werden müssen.

In den nächsten Jahren stehen Unternehmen vor der Herausforderung, die veränderte Anforderungslage architektonisch abzubilden. Dafür können Unternehmen Trends und Innovationen nutzen. Ziel ist es, die Effizienz zu steigern und Kosten zu senken.

4. Daten & Analytics organisieren

Die Organisation von Daten und Analytics fordert Unternehmen schon lange heraus. Die gestiegenen Anforderungen an Agilität und Flexibilität entfachen auch künftig Diskussionen rund um die BI-Organisation.

Wertschöpfende Innovationen aus Daten können meist nur realisiert werden, wenn (Stamm-)Daten in einer zufriedenstellenden Qualität vorhanden sind. Methoden und Konzepte des Stammdaten- und Datenqualitätsmanagements unterstützen Unternehmen bei der Organisation und Pflege von Daten.

5. Daten in Prozessen nutzen

Die vier ersten Ziele führen allesamt zum fünften und letzten Ziel. Unternehmen müssen in Zukunft Daten besser in Prozessen nutzen, um wettbewerbsfähig zu bleiben.

Die Integration von BI in Prozessen kann sogar bis hin zu deren Automatisierung inklusive Entscheidungsfindung führen. Fortgeschrittene Modelle können Mitarbeiter:innen somit gewisse, im Vorfeld klar definierte, Entscheidungen abnehmen.

Self-Service Analytics geht nicht mehr ohne Data Governance

Self-Service Analytics oder Self-Serivce BI war lange die Antwort auf angeforderte Geschwindigkeit und Flexibilität in Unternehmen. Doch auch in den nächsten Jahren bleibt das Thema für Unternehmen herausfordernd. Sie müssen versuchen, weiter wachsende Anforderungen nach Flexibilität und Agilität zu erfüllen, aber gleichzeitig die Anwendungs- und Werkzeug-Landschaften zu ordnen. Wie sieht die Zukunft von Self-Service BI 2022 aus?

Unternehmen haben die letzten Jahre ihre Erfahrungen mit Self-Service gesammelt. Heute sind neue Herausforderungen durch den „ungeschützten“ Einsatz dessen deutlich erkennbar.

Self-Service Analytics muss sich verändern

Die Anforderung von Fachanwender:innen, Adhoc-Auswertungen selbst anfertigen zu können, war ein guter Treiber für den Einsatz von Self-Service BI Tools. Aber viele Unternehmen haben nicht die nötigen Rahmenbedingungen geschaffen, wodurch Anwender:innen zu viel Freiraum gegeben wurde. Die Flexibilität ist in vielen Unternehmen zu weit gegangen.

Das zeigt sich vor allem in der Konsistenz von Reports und Dashboards. Dadurch, dass jede/r Fachanwender:in seine Berichte und dessen Inhalte selbst definieren und berechnen kann, arbeiten verschiedene Mitarbeiter:innen und Abteilungen mit verschiedenen Kennzahlen.

Nun liegen Entscheidern oft Berichte vor, die scheinbar dasselbe beinhalten, aber verschiedene Berechnungen vorweisen. Da jede/r Fachanwender:innen Kennzahlen selbst definiert, lassen sich Berichte oft nicht vergleichen. Unternehmen müssen sich oft fragen: Welche Kennzahlen sind richtig? Woher kommen sie und welche sind aktuell?

Viele Self-Service Tools haben eine eigene Datenhaltung an Board. Das erschwert die Nutzung und Bereitstellung gemeinsamer Kennzahlen. Somit können Kennzahlen nur bedingt für unternehmensübergreifende Zwecke genutzt werden.

Nach Jahren gelebter Praxis stellen sich Unternehmen nun die Frage, wie effizient Self-Service wirklich ist. Steigert es wirklich die Produktivität, wenn sich viele Fachanwender mit Business Intelligence befassen? Müssen gelegentliche Fachanwender:innen alles tun (können)? Wollen Fachanwender:innen vielleicht nicht alles selbst machen?

Wir sehen: Self-Service BI in 2021 braucht einen neuen Anstrich.

Kein Self-Service Analytics ohne Data Governance

Viele Unternehmen versuchen nun, Rahmenbedingungen und Regelwerke zu schaffen. Ist Data Governance die Lösung für Self-Service-Probleme?

Es ist eine Gratwanderung, an der sich Unternehmen künftig versuchen sollten. Zwischen Flexibilität und Freiheit, die Self-Service Business Intelligence bzw. Analytics mit sich bringt und der Kontrolle, die durch unternehmensweite Standards realisiert wird, gilt es die passende Balance zu finden.

Mit einer Governance möchten Unternehmen mehr Kontrolle darüber bekommen, wie Fachanwender:innen mit Kennzahlen und BI-Inhalten umgehen können und dürfen. Dafür bedarf es gewisser Regelungen und Standards, die den Umgang mit Daten und Werkzeugen zentral definieren.

In diesem Zuge muss auch die Datenarchitektur überdacht werden. Dabei könnte sich ein Mix aus zentraler Datenbereitstellung und dezentraler Speicher für Fachbereiche eignen. Zusätzlich bieten sich neue Technologien und Konzepte des Datenmanagements an.

Ein Data Catalog stellt zum einen weiterführende Informationen zu Datenquellen bereit, die Fachanwender:innen flexibel und selbstständig nutzen können. Zum anderen ist der Data Catalog ein Governance-Instrument, in dem Unternehmen Standards und Rahmenwerke steuern können.

Tool-Standardisierung als Lösung?

Durch den Self-Service-Ansatz haben sich teilweise mehrere Tools in einem Unternehmen etabliert. In 2020 werden wir beobachten, wie Unternehmen vermehrt ihre Werkzeuge standardisieren und die Anzahl ihrer Tools reduzieren.

Der Grund dafür war oft, dass vor Jahren jede Software noch eine eigene Nische bediente. Heute ist die Funktionsbreite der Software und deren Überlappungen jedoch so groß, dass Unternehmen auch mit einer geringeren Anzahl an Werkzeugen ihre Anforderungen bedienen können.

Eine Tool-Standardisierung bringt weitere Vorteile mit sich: Schulungs- und Trainingsbedarf kann im Unternehmen skaliert werden. Anwender:innen verschiedener Fachbereiche nutzen zudem vermehrt dasselbe Tool, wodurch Lizenzkosten gespart werden können.

Fazit

Unternehmen wird es zunehmend schwer fallen, eine richtige Balance zwischen Flexibilität und Kontrolle zu finden. Ein Data Governance Framework ist nötig, sollte Fachanwender:innen jedoch nicht zu sehr in ihrer Freiheit einschränken. Denn: Flexibilität bleibt wichtig und ist in Unternehmen weiterhin gefragt.

Es gilt: So wenig wie möglich, so viel wie nötig.

5 Wege, wie Sie Trends erkennen und nutzen

Wir haben Ihnen die Trends vorgestellt, die Unternehmen in allen Branchen umtreiben. Benötigen Sie tiefergehende Hilfe dabei, die für Sie wichtigen Trends zu erkennen und zu nutzen?

BARC gibt Ihnen fünf Tipps:

- Nutzen Sie Research als Wegweiser. Als unabhängiger Spezialist verfügen wir über einen einzigartigen Marktüberblick.

- Lernen Sie mehr über die Umsetzung aktueller Trends von unabhängigen Analysten, anderen Anwendern und Anbietern auf BARC Events

- Erfahren Sie kompakt und konkret, welche neuen Entwicklungen wichtige Impulse für Ihre individuelle IT- und Business-Strategie geben

- Treffen Sie sich zum vertraulichen Austausch mit Peers

- Buchen Sie einen BARC-Analyst:inneen als Sprecher:innen für Ihre Veranstaltung